Die Crawler der Suchmaschinen haben verdammt viel zu tun – mehr als 20 Milliarden Websites mit täglich neuen Inhalten wollen in den Index aufgenommen werden. Wer eine eigene Website online setzt, sollte darauf achten, gleich von Beginn an relevante Signale für die Search Engine Bots zu erzeugen.

Dazu gehört eine gewissenhafte Onpage-Optimierung und natürlich Basics wie die Angabe im robots.txt, überhaupt im Index aufgenommen werden zu wollen. Man kann den Suchmaschinen jedoch noch mit weiteren Maßnahmen unter die crawlenden Arme greifen, damit die neuen Webinhalte besser und schneller von Google und Co. gefunden werden können.

Eine XML Sitemap erstellen und einreichen

Eine Sitemap gibt den Crawlern einen Gesamtüberblick über die zu indexierenden Inhalte. Sie wird in einer XML-Datei ausgegeben, die alle zu durchsuchenden URLs der Website inklusive zusätzlicher Metadaten, letzten Aktualisierungen, URL-Prioritäten und Änderungsverläufen aufführt und den Suchmaschinen so eine Vorstrukturierung zur Registrierung liefert. Unter dem Suchbegriff “XML Sitemap (Generator)” lassen sich einige Seiten finden, über die man seine XML Sitemap erstellen lassen kann.

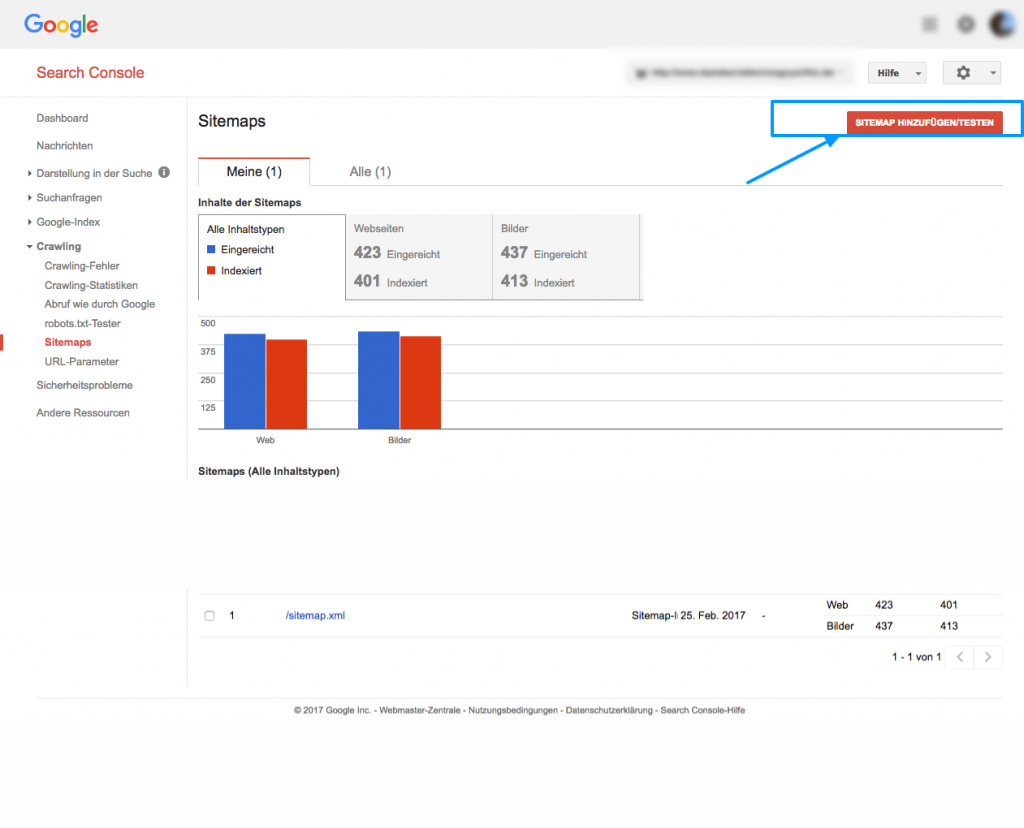

Für Google (immer noch die meistgenutzte Suchmaschine im deutschsprachigen Raum) stehen die Webmaster Tools unter dem neuen Namen Search Console zur Verfügung, bei denen man nach Anmeldung seine Sitemap einreichen und somit signalieren kann, dass die URLs indexiert werden sollen.

Der Indexierungsstatus kann über das SEO Google Tool überprüft und auf Fehler bzw. Erreichbarkeit getestet werden.

Auch Bing bietet diese Möglichkeit über die Bing Webmaster-Tools an.

URL eintragen

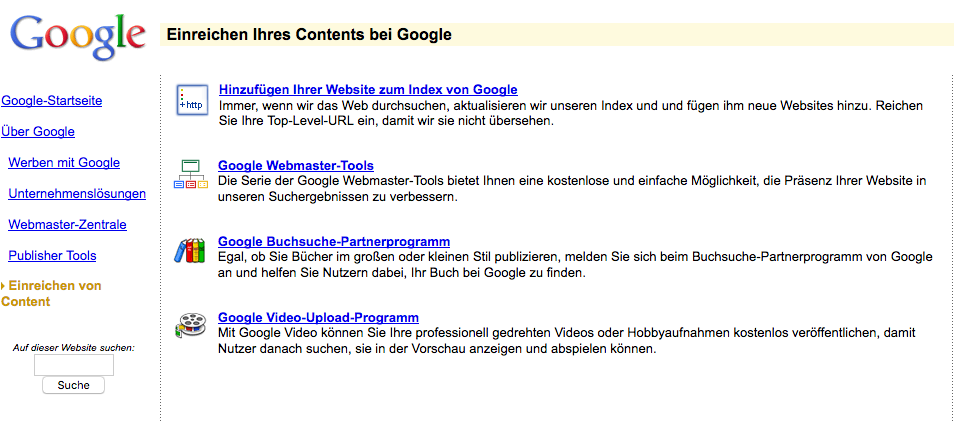

Anstelle oder auch zusätzlich zur Sitemap-Einreichung kann man bei Google seine “Website zum Index von Google” hinzufügen. Google selbst gibt über seine Funktion “Abruf wie durch Google” an:

Über die Funktion “Indexierung beantragen” in “Abruf wie durch Google” können Sie bequem um die Indexierung einiger URLs bitten. Bei vielen URLs ist es einfacher, stattdessen eine Sitemap einzureichen. Die Antwortzeiten sind bei beiden Methoden etwa gleich.

Verlinken lassen

Backlinks können ein wichtiges Signal für Suchmaschinen sein, dass der verlinkte Content (besonders) relevant ist. Aus diesem Grund werden gut und sinnvoll verlinkte Seiten auch besonders häufig gecrawlt. Man sollte sich ergo frühstmöglich um hochwertige Backlinks für seine Website kümmern.

Zur Qualität von Backlinks und wo man sich eher nicht verlinken lassen sollte, wäre ein weiterer ausführender Post notwendig. An dieser Stelle sei deshalb zunächst nur erwähnt, dass man den Bots der Suchmaschinen das Backlink-Crawling erleichtern kann, indem die Website von anderen Seiten möglichst unweit der Startseite verlinkt wird – sprich am besten auf Unterseiten, die maximal sechs Klicks in der Hierarchie der Startseite zu erreichen sind. Je prominenter die Referenz zur eigenen Seite für die Bots erscheint und je schneller Backlinks gefunden werden können, umso besser.

Auch Social Media spielt in diesem Zusammenhang natürlich eine Rolle, sodass frühstmöglich auf “Social Signals” für die Crawler der Suchmaschinen hingearbeitet werden sollte.

“Quick and Dirty” Indexierungsabfrage to Go

Abseits der (empfohlenen, weil genaueren) Datenangabe zum Indexierungsstatus in der Search Console, kann man die bereits vom Google-Bot registrierten URLs mit dem Suchbefehl site:www.ihre-domain.de abfragen.